みなさんこんにちは。ネクストシステムの広報担当田中です。ご存知の方もいらっしゃるかもしれませんが、5月13日(月)に弊社からiOSアプリをApp Storeにて公開させていただきました。その名も、

「ミチコン-VisionPose Single3D-」!!!

ダウンロードはこちらからどうぞ。

https://apps.apple.com/jp/app/id1461437373

※「ミチコン-VisionPose Single3D-」は配信を停止し、現在は更にパワーアップした「ミチコンPlus」を配信しております。お手数ですがこちらをDLいただけますと幸いです。

というわけで。

今回はミチコンのアプリ説明と、オススメの使い方についてご説明させていただこうと思います。

もくじ

ミチコン-VisionPose Single3D-とは?

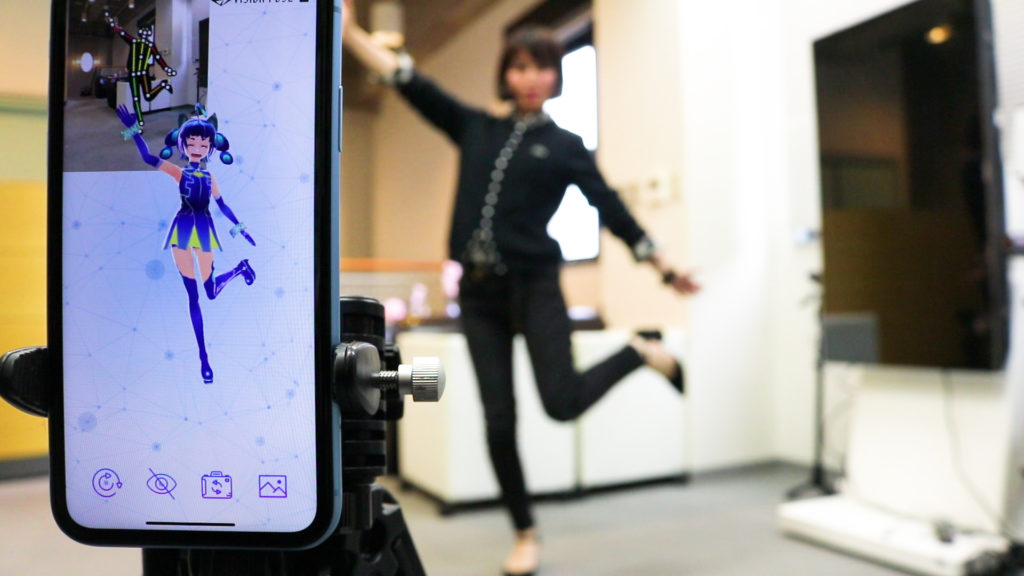

「ミチコン-VisionPose Single3D-」とはスマートフォンで全身のリアルタイムモーションキャプチャを行い、動きを弊社のバーチャル広報担当「未確認仮想広報担当ミチコ」ちゃんに反映するアプリです。

みたほうが早い!プロモーション動画をまずはご覧ください。

ちなみに名前の由来は「ミチコをコントロールできる」ところから。リモコンともかかってます。

動画でだいたいイメージは伝わったのでは、と思いますが簡単にアプリのご説明をするとこんな感じです。

・スマホカメラだけで全身モーションキャプチャ

通常、モーションキャプチャを行う際はカメラを複数台用意し、対象にデバイスを装着する必要がありますが、

なんとミチコンでは、

特別なデバイスを体には一切装着する必要なし!

スマホカメラだけで全身のモーションキャプチャが可能!

となっています。

従来のフルトラッキングは多額の初期投資が必要であることを考えると、ローコストですよね。

・グリーンバック機能搭載!VTuber配信にも!

配信にもご利用しやすいよう、グリーンバック機能を搭載しました。

OBSなど別途配信ツールを利用すると、クロマキー合成も可能です。配信ネタなどにどうぞ。

ちなみに広報担当は、簡単なものならPerfect Videoなどのスマホアプリでサクッと編集してます。アプリだけで動画編集が完了するって最高か。。。

ちなみに、ミチコンのグリーンバック機能で撮影して、Perfect Videoっていう編集アプリでクロマキー合成してみたんですけど、スマホだけでここまで完結できるの本当すごい・・・。

— 株式会社ネクストシステム【公式】 (@NEXT_SYSTEM_Co) May 23, 2019

・未確認仮想広報担当ミチコになりきれる!

未確認広報担当ミチコとは、広報担当として株式会社ネクストシステムの歴史を学ぶべく、そう遠くない未来から仮想空間を介して新人研修にやってきた女の子です。基本的には電脳空間にいるので、社員のPCなどに表示されてることが多いです。

この姿は仮想空間上でのアバターのようなものらしく、体が3DCGでできていることを活かしてアプリのモデルとして協力してもらっています。

ミチコンを作ることになったきっかけ

弊社は2018年の11月より「VisionPose(ビジョンポーズ)」というカメラだけで人間の骨格を検出するシステムを提供しています。

そんなVisionPoseシリーズの1つで、カメラ1つで人の骨格座標を3Dで予測できる「VisionPose Single3D(以下 Single3D)」を現在開発しているのですが、その利用例として2019年3月に公開したデモアプリに、大変多くのご反響が・・・!

というわけで、ユーザーの皆様にもご体験いただけるよう、この度正式アプリとしてApp Storeより公開することになったことがきっかけです。

3月に公開したデモアプリ。Twitterを中心に多くのご反響をいただきました。

ミチコンに利用されている「VisionPose Single3D」の詳細は以下URLからご確認ください。

ミチコンを上手に動かす方法

どうせなら綺麗に3Dモデルを動かしたいですよね。

ミチコンを上手に動かすためには、Single3Dが認識しやすい環境を整える必要があります。そこで特に影響がある3点をご紹介します。

身体の線がわかりやすい服がおすすめ!

ミチコンはカメラ画像から人間の骨格位置を推定して動きを検出しています。

人間に置き換えるとわかりやすいのですが、人間の目がVisionPoseでいうカメラだとすると、例えばロングスカート着ている人の足が、クロスしているかどうかって人間でも見た目だけじゃわかりにくいですよね。

それと一緒で、オーバーサイズや、ロングの服を着ていると、

「足が見えないので、できる限りの想像でやらせてもらいますけど、あんまり自信ないです」状態になってしまうので、どうしても精度は落ちてきます。

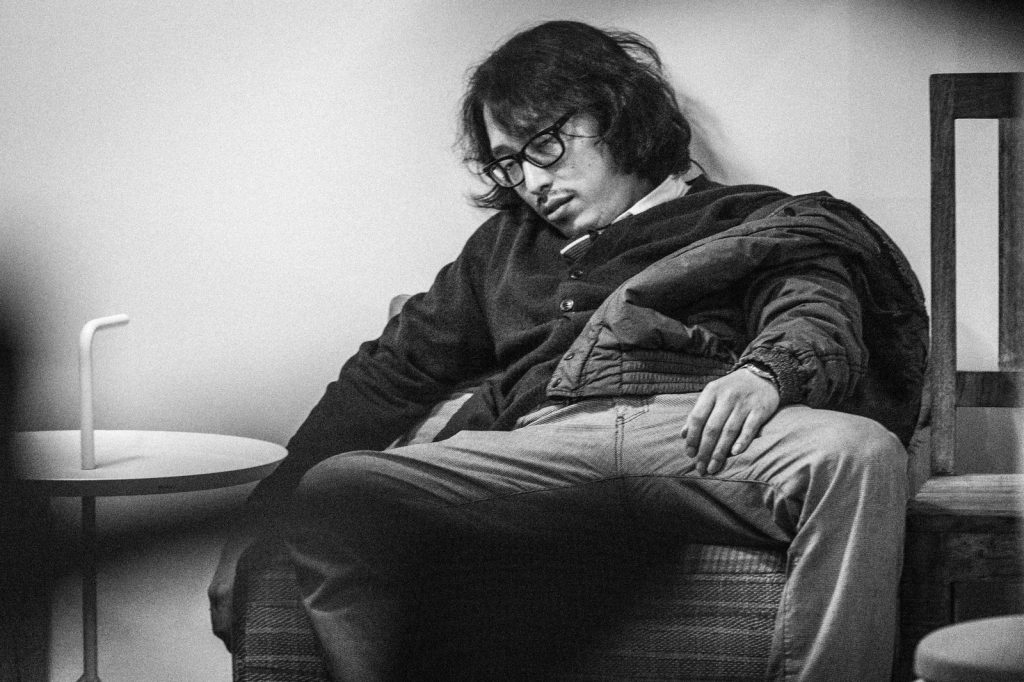

現状、身体の線が出にくい服をきたときの精度はこんな感じ。

正確にはミチコンで利用している Single3Dではなく、VisionPose Standardの方の実験動画になります。

そこそこ頑張っている感はありますが、0:57~あたりのゆったりサロペットだとVisionPoseが誤認識してるところがありますよね。

もちろん弊社では日々学習を行うことで精度を調整していってはいますが、より精度を求めるのであれば、体の線がわかりやすい服装であることをお勧めします。

というわけでオススメの服装を具体的にいうと

まあ、私みたいな格好ですかね!

タイトなジーンズにタイトめのトップス、ねじ込んでみてください。

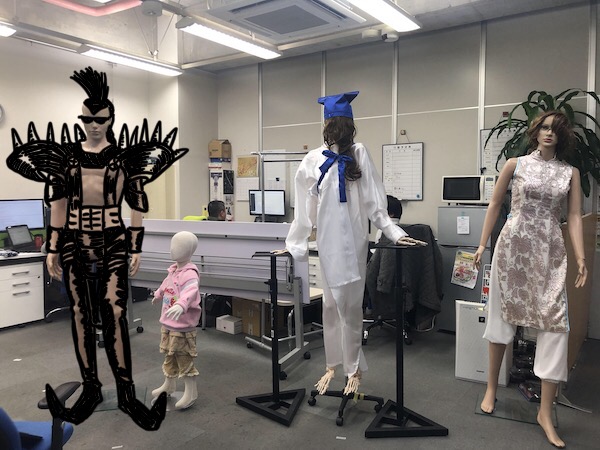

背景をできるだけシンプルに

弊社のように、背景に色んなパターンのマネキンが写り込みがち、という環境の方も多いかと思います。え?そんなことない?

ミチコンをご利用いただく際は、出来るだけごちゃごちゃしてない背景のほうが望ましいです。

具体的なチェック方法としては、ミチコンの画面上での確認がおすすめです。

ミチコンを起動してプレビュー画面を表示すると、体の上にボーンが表示されます。このボーンが背景に写っている物体に取られていないか確認してみて、邪魔なものがあれば取り除いてみると、より安定してミチコンをお楽しみいただけます。

ちなみにミチコンの仕様としては、認識人数は1人でかつ、画面中央に写っている人物の骨格が採用されます。仕様をご理解いただき、最高の環境で撮影してみてくださいね!

A12を搭載した推奨スペックの端末を用意

これをすぐ実現するのはめちゃくちゃ難しいと思うのですが、推奨スペックの端末であるかどうかで、ミチコンのパフォーマンスがかなり違います。

現在のミチコンの推奨端末は下記。

- iPhone XS / XS MAX

- iPhone XR

そういえば、ミチコンをリリースさせていただいていてからコメントを楽しく拝見していたのですが、同じiPhoneXシリーズでもXのプロセッサがA11なのに対し、XSやXRのプロセッサがA12でおばけ処理スピードに進化していることはあまり知られていない気がしました。

毎秒5兆の演算処理に、Core MLの動作がA11と比べて最大9倍高速ですって。

いや5兆って、小学生特有の仮想通貨の単位かよ。

というわけで、iPhoneXだとFPSが大分落ちますので、できればXS、XR以上をお勧めします。

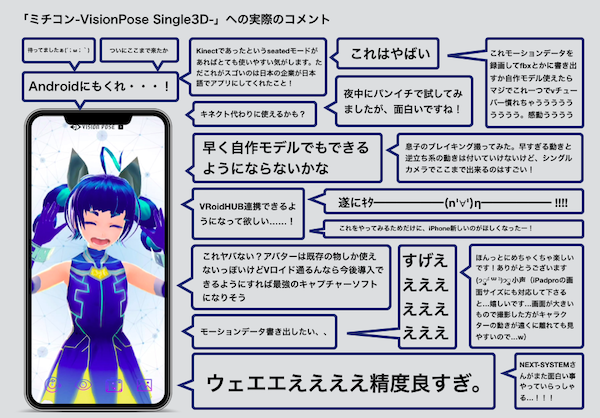

ミチコンをリリースをした際の反応は?

ミチコンをリリースさせていただいた際のコメントはどんなものだったのでしょうか?一部コメントを抜粋しまとめてみました。

ウッヒョオ・・・・。

iOSアプリは辛辣なコメントが多いと聞きますし、相当手厳しい声をいただくんだろうなと覚悟して、「南無三!」と公開した弊社でしたが、思ったより暖かい声が多くて驚きました。

ありがたくご意見を拝見したところ、

- Android対応

- オリジナルキャラクターの読み込み

というご意見が多かったです。

ミチコンの今後の展望は?

現在のミチコンは、弊社の技術を少し体験できるアプリであるだけで、”使えるアプリ”とまではいっていません。そこで、いただいたご意見をまとめて社内で企画会議を開催しました。

ミチコンは今後大まかにこんなことができるようになる予定です。

- オリジナルキャラクターの取り込み

- モーションデータの書き出し機能

- iPad対応

まずこのあたりの機能があればもっと楽しんでいただけるのでは、と考えております。

ただ、Android方は、、、すみません!

実は、弊社のシステムの都合上、条件を満たした端末がなくて作れないのです 。

今後スペックを満たすAndroidハードウェアが登場したら作ることになるかもしれません。せっかくのご意見を反映できず申し訳ない・・・!

まとめ

というわけで今回はミチコンの正しい使い方についてまとめてみました。

それにしてもこないだのAppleさんの発表。

いや、ARkit3でモーショントラッキング出るんかーい!!

そんな正直な気持ちを吐露しつつ、まだベータ版なので調査結果を公には出せませんが、弊社の方でも現在調査を進めています。

弊社の方針としては基本的に、「技術は目的ではなく、手段である」と考えてます。そのため、もしARkit3の方がユーザーの皆様にとって良いと感じたら、そちらを今後採用する可能性もあります。(長い物には大いに巻かれていくスタイル)。

でも、もともとSingle3Dの利用例としてリリースしたアプリだったので広報担当的には正直、「タイミング!もっと考えていこ!お願いだから!」って感じなんですけどね(個人の感想です)

対してVisionPoseは

・複数人検出に強い

・iOS以外のOS(Win C#/C++、Linux、Jetson、Cloudなど)もカバー

・自社製品であることで、キーポイントの数など、ある程度コントロールできる

などが強みになってきます。

ARkit3の仕様内で勝負するとアプリ自体のクオリティ勝負になってしまいますし、自社でコントロールできるVisionPoseの方が、もしかしたら他のアプリにはない機能をご提供できるかもしれません。

これらの優位性とARkit3、どちらを取るか悩みどころ・・・

そんな私個人の思惑は置いておいて、会社としては柔軟に対応する方針です。

もちろん、ミチコンに搭載されたAI骨格検出システムVisionPose自体もSDKを提供させていただいてます。

この辺りに有用性を感じていただけたお客様がいらっしゃいましたら全力でご対応させていただきたいと思いますので、ぜひお気軽にご一報くださいませ^^。

弊社の最新情報は下記Twitterからどうぞ。

ではでは!

9/5キャラクター変更、モーションキャプチャ書き出しに対応した「ミチコンPlus」がリリースされました。

ご要望の多かった、

・キャラクター変更

・モーションキャプチャ書き出し

・iPad対応

などに対応した「ミチコンPlus」がリリースされました!

モーションキャプチャを行うためには、機材を揃えたり、スタジオで撮影したりする必要があり、ハードルが高くコストの面からみても手軽とはいえませんでした。ミチコンPlusではスマートフォン1台で可能な上、1ヶ月定額で使い放題であるため、手軽なアニメーション作成をサポートします。

対応端末は下記。これ以下のスペックだと動かすとスローモーションみたいな動きになっちゃいます。

iPhone XS/XS MAX/XR

iPhone 11~

iPhone SE(2nd〜)

iPad mini(5th)/Air(3rd~)/Pro 11inch(1st~)/Pro 12.9inch(3rd~)

iPad(8th)

まずはデフォルトで利用できる弊社バーチャル広報の「ミチコ」で試してみてくださいね^^

詳細は以下からご覧ください。